Grandes Modelos De Lenguaje: Conceptos, Técnicas Y Aplicaciones, De John Atkinson-abutridy., Vol. 1. Editorial Alfaomega Grupo Editor, Tapa Blanda, Edición 1ra Edición En Español, 2023

Mismo precio en 3 cuotas de

Precio sin impuestos nacionales:

Lo que tenés que saber de este producto

- Año de publicación: 2023

- Con índice: Sí

- Volumen del libro: 1

- Tapa del libro: Blanda

- Género: Informática y tecnología.

- Subgénero: Programación.

- Técnica.

- Número de páginas: 284.

- Dimensiones: 16cm de ancho x 23cm de alto.

- Peso: 625g.

- ISBN: 09789878983790.

Opciones de compra:

Características del producto

Características principales

Título del libro | Grandes modelos de lenguaje |

|---|---|

Subtítulo del libro | Conceptos, técnicas y aplicaciones |

Autor | JOHN ATKINSON-ABUTRIDY |

Idioma | Español |

Editorial del libro | Alfaomega Grupo Editor |

Edición del libro | 1ra Edición |

Es kit | No |

Tapa del libro | Blanda |

Volumen del libro | 1 |

Con índice | Sí |

Año de publicación | 2023 |

Otros

Cantidad de páginas | 284 |

|---|---|

Altura | 23 cm |

Ancho | 16 cm |

Peso | 625 g |

Material de la tapa del libro | Vinil |

Con páginas para colorear | No |

Con realidad aumentada | No |

Género del libro | Informática y tecnología |

Subgéneros del libro | Programación |

Tipo de narración | Técnica |

Con cierre | No |

Escrito en imprenta mayúscula | Sí |

ISBN | 09789878983790 |

Descripción

Título: Grandes modelos de lenguaje - Conceptos, técnicas y aplicaciones

ISBN: 9789878983790

Autor: John Atkinson-Abutridy

Edición 1ra.

Año: 2023

Editorial: Alfaomega - Marcombo

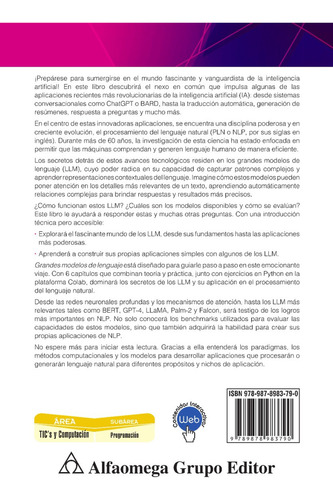

Sumérjase en el mundo fascinante y vanguardista de la inteligencia artificial. En este libro descubrirá el nexo en común que impulsa algunas de las aplicaciones recientes más revolucionarias de la inteligencia artificial (IA): desde sistemas conversacionales como ChatGPT o BARD, hasta la traducción automática, generación de resúmenes, respuesta a preguntas y mucho más.

En el centro de estas innovadoras aplicaciones se encuentra el procesamiento del lenguaje natural (PLN o NLP, por sus siglas en inglés). Durante más de 60 años, la investigación de esta ciencia ha estado enfocada en permitir que las máquinas comprendan y generen lenguaje humano de manera eficiente.

Los secretos detrás de estos avances residen en grandes modelos de lenguaje (LLM), cuyo poder radica en su capacidad de capturar patrones complejos y aprender representaciones contextuales del lenguaje. Imagine cómo estos modelos pueden poner atención en los detalles más relevantes de un texto, aprendiendo automáticamente relaciones para brindar respuestas y resultados más precisos.

¿Cómo funcionan estos LLM? ¿Cuáles son los modelos disponibles y cómo se evalúan? Este libro le ayudará a responder estas y muchas otras preguntas. Con una introducción técnica pero accesible.

• Explorará el fascinante mundo de los LLM, desde sus fundamentos hasta las aplicaciones más poderosas.

• Aprenderá a construir sus propias aplicaciones simples con algunos de los LLM.

Grandes modelos de lenguaje está diseñado para guiarle paso a paso en este emocionante viaje. Con 6 capítulos que combinan teoría y práctica, junto con ejercicios en Python en la plataforma Colab, dominará los secretos de los LLM y su aplicación en el procesamiento del lenguaje natural.

Desde las redes neuronales profundas y los mecanismos de atención, hasta los LLM más relevantes tales como BERT, GPT-4, LLaMA, Palm-2 y Falcon, será testigo de los logros más importantes en NLP. No solo conocerá los benchmarks utilizados para evaluar las capacidades de estos modelos, sino que también adquirirá la habilidad para crear sus propias aplicaciones de NLP.

No espere más para iniciar esta lectura. Gracias a ella entenderá los paradigmas, los métodos computacionales y los modelos para desarrollar aplicaciones que procesarán o generarán lenguaje natural para diferentes propósitos y nichos de aplicación.

Tabla de contenido

índice de figuras XIX

índice de tablas XXII

CAPÍTULO 1

1.1 Inteligencia artificial generativa. 1

1.1.1. Funcionamiento de la IA generativa. 3

1.1.2. Focos de la IA generativa. 6

1.1.3. Aplicaciones. 7

1.2. Modelos de lenguaje generativos. 8

1.3. Conclusiones. 14

CAPÍTULO 2

2.1. Introducción. 15

2.2. Modelos de lenguaje autorregresivos. 19

2.3. Modelos de lenguaje estadísticos. 21

2.4. Modelos de lenguaje neuronales. 22

2.4.1. Modelos preentrenados. 25

2.5. Grandes modelos de lenguaje. 26

2.6. Modelos de embeddings de palabras. 27

2.7. Redes neuronales recurrentes. 35

2.7.1. Redes neuronales recurrentes simples. 35

2.7.2. Redes de memoria a corto-largo plazo. 40

2.8. Autoencoders 44

2.8.1. Cuello de botella de la información. 46

2.8.2. Variables latentes. 47

2.8.3. Arquitectura de un Autoencoder. 49

2.8.4. Tipos de Autoencoders. 50

2.9. Redes adversarias generativas. 56

2.10. Modelos de atención. 59

2.10.1. Problema del encoder-decoder. 61

2.10.2. Atención en modelos de secuencia. 63

2.11. Transformers. 80

2.11.1. Capa del encoder 84

2.11.2. Codificación posicional. 85

2.11.3. Conexiones residuales. 89

2.11.4. Capa del decoder

2.11.5. Capa lineal y SoftMax 93

2.11.6. Entrenamiento. 94

2.11.7. Inferencia. 96

2.11.8. Función de pérdida. 98

2.12. Conclusiones

CAPÍTULO 3

3.1. Introducción. 101

3.1.1. Habilidades emergentes. 102

3.1.2. Técnicas de mejoramiento de capacidades. 104

3.1.3. Corpus comunes. 105

3.1.4. Tipos de entrenamiento. 106

3.1.5. Tipos de aprendizaje. 107

3.1.6. Tipos de tokenización 109

3.2. BERT. 110

3.2.1. Funcionamiento. 112

3.2.2. Arquitectura. 115

3.2.3. Entrada del modelo. 115

3.2.4. Salida del modelo

3.2.5. Modelos preentrenados basados en BERT. 118

3.3.1. GPT. 119

3.3.2. El modelo GPT y GPT-2. 121

3.3.3. El modelo GPT-3. 131

3.3.4. Reinforcement Learning from Human Feedback. 135

3.4. PaLM. 140

3.4.1. Vocabulario. 143

3.4.2. Entrenamiento. 144

3.4.3. PaLM-2. 145

3.5. LLaMA. 148

3.5.1. Datos de preentrenamiento. 149

3.5.2. Arquitectura. 150

3.6. LaMDA. 151

3.6.1. Objetivos y métricas. 153

3.6.2. Preentrenamiento de LaMDA. 154

3.7. MEGATRON. 156

3.7.1. Datos de entrenamiento. 159

3.8. Otros LLM. 160

3.9. Conclusiones. 162

CAPÍTULO 4

4.1. Introducción. 165

4.2. Tareas de evaluación. 166

4.2.1. Tareas básicas de evaluación. 167

4.2.2. Tareas avanzadas de evaluación. 171

4.2.3. Tareas de cumplimiento de regulaciones. 172

4.3. Métricas y puntos de referencia. 176

4.4. Datasets de Benchmark. 178

4.4.1. SQuAD (Stanford Question Answering Dataset). 178

4.4.2. GLUE (General Language Understanding Evaluation). 179

4.4.3. SNLI (Stanford Natural Inference). 180

4.4.4. ARC (Abstraction and Reasoning Corpus). 180

4.5. Evaluación de LLM. 181

4.6. Conclusiones. 186

CAPÍTULO 5

5.1. Introducción. 189

5.2. Clasificación de sentimientos. 190

5.3. Búsqueda semántica en textos. 197

5.4. Razonamiento con agentes de lenguaje. 198

5.5. Inferencia causal. 201

5.6. Acceso a bases de datos en lenguaje natural. 203

5.7. Cargando y preguntando por datos propios. 206

5.8. Realizando ajuste fino de un modelo con datos propios. 209

5.9. Diseño y optimización de prompts. 214

5.10. Sistema conversacional ChatGPT. 221

5.11. Sistema conversacional BARD. 229

5.12. Conclusiones. 231

CAPÍTULO 6

6.1. Introducción 233

6.2. Habilidades emergentes. 234

6.3. LLM en producción. 236

6.4. Alineación entre humanos y LLM. 238

6.5. Ética 240

6.6. Aspectos regulatorios. 242

6.7. Complejidad 243

6.8. Riesgos. 244

6.9. Limitaciones. 245

6.10. Conclusiones. 247

Índice onomástico. 249

Bibliografía. 253

Alfaomega

Tienda oficial de Mercado Libre

+100 Seguidores

+1000

Ventas concretadas

Brinda buena atención

Despacha sus productos a tiempo

Otras opciones de compra

Medios de pago

Cuotas sin Tarjeta

Tarjetas de crédito

Tarjetas de débito

Efectivo

Preguntas y respuestas

¿Qué querés saber?

Nadie hizo preguntas todavía.

¡Hacé la primera!

Publicación #1450485343

DenunciarSe abrirá en una nueva ventana